姚前:关于大模型生态建设的若干思考

2023-07-11 08:21:44

进入2023年,ChatGPT、GPT4以及Midjourney等以内容生成為(wèi)导向的人工智能(néng)应用(yòng),引发了一轮又(yòu)一轮的创新(xīn)浪潮。有(yǒu)人甚至认為(wèi),大模型正在以日為(wèi)单位迭代进化。作為(wèi)新(xīn)型生产要素,大模型训练数据的良性可(kě)持续发展,对于大模型和人工智能(néng)产业的发展至关重要。金融业作為(wèi)大数据和人工智能(néng)应用(yòng)的重要领域,理(lǐ)应密切关注当前大模型训练相关技术的最新(xīn)态势。本文(wén)首先分(fēn)析大模型的进化与升级路径,之后通过探讨大模型和中小(xiǎo)模型可(kě)能(néng)的交互方式,阐述大模型的数据生态和模型生态建设,為(wèi)保障产业安全健康发展、规避数据和技术风险以及构建可(kě)持续发展的大模型生态提供相关思路。

大模型的升级与进化路径分(fēn)析

从長(cháng)期视角来看,大模型的进化衍生出众多(duō)分(fēn)支。最近一段时间,大模型迭代不仅速度加快,而且参与者也越来越多(duō),基本上涵盖了所有(yǒu)的大型科(kē)技公司,生态的多(duō)样性和复杂性已初步显现。

目前,大模型升级迭代过程中的底层算法框架并没有(yǒu)本质的变化,算力投入以及训练数据的丰富仍然是其快速进化的关键,只不过最新(xīn)的GPT4呈现出一些新(xīn)的特征。

一是算法方面更适配具體(tǐ)的下游任務(wù)。GPT3与GPT3.5都是1750亿参数的大模型。GPT4目前没有(yǒu)公布具體(tǐ)参数,但有(yǒu)人推测其参数将达到万亿级别,同时在强化學(xué)习和解决具體(tǐ)任務(wù)方面也将有(yǒu)显著提升,比较流行的术语是“对齐”(Alignment)。如果说GPT3系列模型向大家证明了人工智能(néng)能(néng)够在一个模型里做多(duō)个任務(wù),那么GPT4则在很(hěn)多(duō)任務(wù)上已经达到甚至超过人类水平,比如,在律师等专业學(xué)术考试上,分(fēn)数能(néng)够达到应试者前10%左右的水平。

二是具备更规范的训练数据治理(lǐ)能(néng)力且支持多(duō)模态。GPT4拥有(yǒu)“堪比人脑”的多(duō)模态能(néng)力,跟目前很(hěn)多(duō)论文(wén)阐述的多(duō)模态机理(lǐ)并无太多(duō)差别,但它能(néng)够把文(wén)本模型的少样本处理(lǐ)能(néng)力和思维链(Chain of Thought,CoT)结合进来。GPT4训练数据的治理(lǐ)与供给,离不开数据标注、数据管理(lǐ)与评估、数据自动化以及数据合成。

三是构建更强大的算力集群,以满足更多(duō)的训练数据集和更大的输入参数。例如,微软已经将超过一半的云资源投入大模型训练与人工智能(néng)生成内容(AIGC)应用(yòng)。英伟达更是与台积電(diàn)、荷兰阿斯麦、新(xīn)思科(kē)技强强联手,打造全新(xīn)的算力平台与更强大的GPU。

构建各类模型相互联通的生态

GPT类大模型功能(néng)强大,在未来会成為(wèi)许多(duō)行业如互联网、金融、医疗等领域的重要基础设施之一。例如,在金融领域,经过相关专业数据的训练,大模型可(kě)以具备理(lǐ)解金融业務(wù)知识的能(néng)力,并能(néng)针对具體(tǐ)场景提出解决方案,支持金融机构开展营销自动化、客户关联关系挖掘、智能(néng)风险识别、智能(néng)客服、智能(néng)投研等。

但在具體(tǐ)应用(yòng)落地的过程中,GPT类大模型还会面临一系列挑战。一是如何确保训练数据的数量与质量。一般而言,大模型的训练语料為(wèi)来自于多(duō)个领域的通用(yòng)语料,而专业语料的收集通常比较耗时费力,同时也存在隐私问题,由此导致大模型在具體(tǐ)的个别应用(yòng)领域可(kě)能(néng)出现专业性不足的情况。二是如何降低大模型的运行和维护成本。大模型需要巨大的算力支持和严格的数据治理(lǐ),普通的机构和应用(yòng)部门往往难以支撑大模型的运行以及迭代升级工作。為(wèi)此,需要建立一个各类模型健康交互和协同进化的生态,以保证大模型相关人工智能(néng)产业可(kě)以在各个应用(yòng)领域成功落地。

从技术角度来分(fēn)析,大模型的进化依靠人工反馈的强化學(xué)习(Reinforcement Learning from Human Feedback,RLHF),其采用(yòng)的数据标注与过去那种用(yòng)低成本劳动力完成的简单数据标注工作有(yǒu)所不同,需要非常专业的人士来写词条,针对相应的问题和指令,给出符合人类逻辑与表达的高质量答(dá)案。但由于人工与机器的交互存在一定的隔阂,比较理(lǐ)想的模式是通过模型之间的交互来进行强化學(xué)习,即依靠模型反馈的强化學(xué)习(Reinforcement Learning from Model Feedback,RLMF)。基于各类模型的交互,可(kě)以将整个大模型的数据和模型生态统一為(wèi)一个框架。

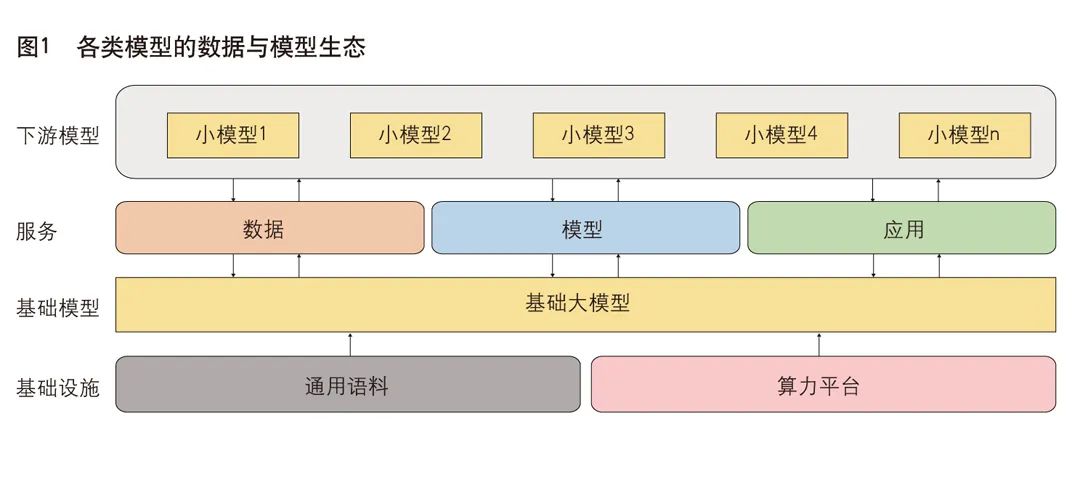

过去,在分(fēn)散化的模型研发模式下,单一的人工智能(néng)应用(yòng)场景下多(duō)个任務(wù)需要由多(duō)个模型共同支撑完成,每一个模型建设都要经历算法开发、数据处理(lǐ)、模型训练与调优过程。预训练大模型增强了人工智能(néng)的通用(yòng)性、泛化性,基于大模型通过零样本或小(xiǎo)样本精调,就可(kě)在多(duō)种任務(wù)上取得较好效果。大模型“预训练+精调”模式為(wèi)人工智能(néng)研发带来了新(xīn)的标准化范式,使人工智能(néng)模型可(kě)以在更统一、更简明的方式下实现规模化生产。围绕技术创新(xīn)与应用(yòng)落地,大模型的数据和产业生态可(kě)划分(fēn)為(wèi)基础设施(包括通用(yòng)语料及算力平台)、基础大模型、大模型服務(wù)(包括合成数据、模型供给及应用(yòng)插件)。在下游应用(yòng)中,用(yòng)户可(kě)以部署自己的小(xiǎo)模型,通过大模型的各种服務(wù)来提升性能(néng),同时也可(kě)反向给大模型提供相应的反馈服務(wù),帮助大模型迭代进化(见图1)。

基础大模型是大模型产业生态的核心引擎,其优势在于基础性和通用(yòng)性,面向典型任務(wù)如自然语言处理(lǐ)、计算机视觉、跨模态任務(wù)等需求,进一步结合任務(wù)特性,优化模型算法,學(xué)习相关数据与知识,从而使大模型表现出更优异的效果,甚至可(kě)以零样本直接应用(yòng)。

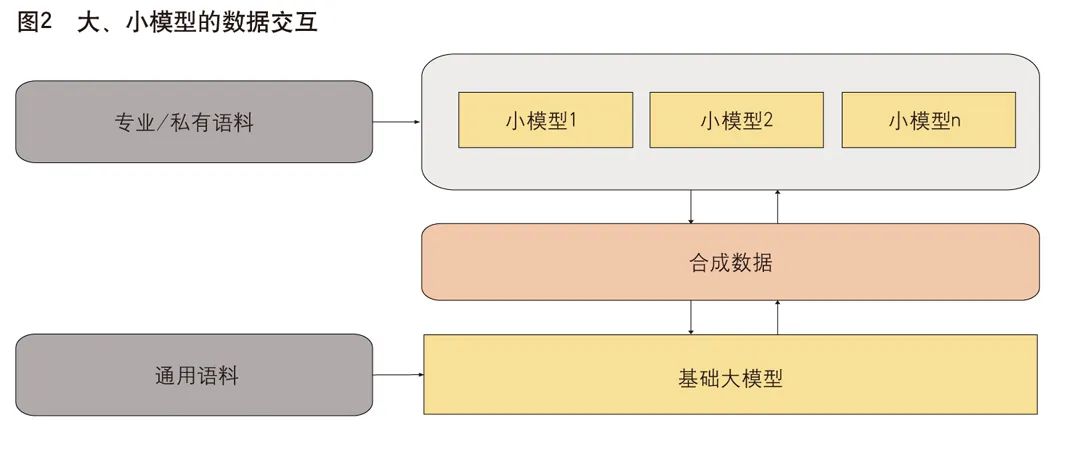

小(xiǎo)模型具有(yǒu)體(tǐ)量小(xiǎo)(通常在百亿参数级别)、易于训练及维护的特点,因此适合各垂直领域,适合各行业进行内部开发和使用(yòng)。在通常情况下,小(xiǎo)模型训练成本较低,但性能(néng)遠(yuǎn)不及大模型。通过大、小(xiǎo)模型交互应用(yòng),可(kě)以让小(xiǎo)模型获得大模型的部分(fēn)能(néng)力或实现部分(fēn)功能(néng),从而在不增加运维成本的前提下,使小(xiǎo)模型的性能(néng)得到较大提升,满足具體(tǐ)的应用(yòng)需求。大、小(xiǎo)模型交互的方式可(kě)以分(fēn)為(wèi)三类:数据交互、模型交互和应用(yòng)交互(见图2)。

数据交互

数据交互是指大、小(xiǎo)模型不直接参与彼此的训练或推理(lǐ)过程,而是间接通过彼此产生的数据来进行交互。大模型的训练通常需要大规模的通用(yòng)语料,如GPT3的训练语料多(duō)达753GB,来自维基百科(kē)等多(duō)个数据源。通用(yòng)语料指的是覆盖多(duō)个领域的语料,在某些特定领域的知识覆盖可(kě)能(néng)存在不足。大模型训练完成后,可(kě)以通过指令生成一些特定领域的合成语料,再通过本地化部署,连同该领域的专用(yòng)语料或行业内的私有(yǒu)语料一起训练小(xiǎo)模型。小(xiǎo)模型训练语料的领域比较集中,因此可(kě)以系统掌握本领域的知识,从而使模型的输出更专业、更细致、更精准。大模型在这一过程中的作用(yòng)是产生大规模的高质量合成语料,使小(xiǎo)模型的训练可(kě)以更加充分(fēn),防止专用(yòng)语料或私有(yǒu)语料因规模小(xiǎo)而导致模型的过度拟合。反之,小(xiǎo)模型生成的专业语料,也可(kě)以作為(wèi)大模型训练语料的补充,增强大模型在不同领域的专业能(néng)力,使大模型可(kě)以不断迭代进化。

实现大、小(xiǎo)模型的数据交互,除了要依靠数据源管理(lǐ)机构外,还需考虑建立数据托管和交易机构,使得大、小(xiǎo)模型的训练数据可(kě)以有(yǒu)序管控和流动,并為(wèi)各方合理(lǐ)分(fēn)配相应的权益。

模型交互

除了间接的数据交互之外,大、小(xiǎo)模型还可(kě)在模型层面进行交互,通过参与彼此的训练过程,使得双方可(kě)以共同受益,提升大模型的迭代效率。一方面,大模型可(kě)以指导小(xiǎo)模型的训练,常用(yòng)的方式為(wèi)蒸馏學(xué)习(Knowledge Distillation)。在蒸馏學(xué)习模式中,训练好的大模型可(kě)以作為(wèi)教师模型,待训练的小(xiǎo)模型作為(wèi)學(xué)生模型,针对同一批训练数据,通过设计合理(lǐ)的损失函数,将大模型产生的软标签与训练数据本身的硬标签对小(xiǎo)模型的训练进行联合指导。同样,小(xiǎo)模型也可(kě)对大模型进行反向蒸馏,利用(yòng)小(xiǎo)模型做样本价值判断帮助大模型加速收敛——将训练好的小(xiǎo)模型在下游数据集上进行进一步微调之后,得到样本价值判断模型。

应用(yòng)交互

大、小(xiǎo)模型在应用(yòng)层面进行交互的典型方式為(wèi)插件模式,即将模型构建的应用(yòng)封装為(wèi)插件服務(wù)供其他(tā)模型调用(yòng)。插件模式具有(yǒu)两大优点:一是便捷高效,模型无需重复训练;二是隔离性好,可(kě)以避免模型细节的泄露,从而更好地保护模型训练方和使用(yòng)方的权益。

一方面,大模型基本上采用(yòng)预训练方式,实时性不高。通过调用(yòng)小(xiǎo)模型应用(yòng)插件,大模型应用(yòng)不仅可(kě)以提高输出结果的实时性,也可(kě)以扩展自身在特定领域的知识缺失。另一方面,小(xiǎo)模型构建的应用(yòng)也可(kě)以通过调用(yòng)GPT类大模型提供的插件,直接获得大模型强大的生成能(néng)力和推理(lǐ)能(néng)力。这种应用(yòng)交互方式可(kě)以让小(xiǎo)模型免去通用(yòng)知识的训练过程,以较低成本来专注于特定领域的内容生产,用(yòng)户也可(kě)以感受到各类模型互联互通后产生的“化學(xué)”反应。

开放人工智能(néng)(Open AI)近期发布的新(xīn)产品ChatGPT plugins可(kě)以通过应用(yòng)插件连接ChatGPT与第三方应用(yòng)。这些第三方应用(yòng),可(kě)以是由单个领域的小(xiǎo)模型构建而成。通过这种方式,小(xiǎo)模型可(kě)以在ChatGPT类的大模型中完成多(duō)种扩展功能(néng),如检索实时资讯或知识库信息、代替用(yòng)户对现实世界进行“智能(néng)调度”等。

大模型训练数据与模型工具链的标准化和安全管控

大模型的性能(néng)依赖于训练数据的质量,同时,模型在不同落地场景下所需的底层技术规格也不尽相同。因此,构建大模型持续发展、健康交互的良好产业生态,必须推进大模型训练数据与底层技术的标准化,加快模型的迭代与落地。

一方面,大模型自身的训练数据集以及定义的数据服務(wù)接口(API),将会成為(wèi)行业的事实标准,而接入大模型的各种应用(yòng)都必须遵循该标准。目前,模型“预训练+微调”已经成為(wèi)行业统一的标准流程和范式。在此基础上,结合具體(tǐ)的应用(yòng)场景和专业数据,可(kě)以进一步定制和优化各领域各行业的小(xiǎo)模型。从某种程度上来说,大模型训练数据和数据服務(wù)接口标准,将会成為(wèi)下一代國(guó)际标准的核心之一。

另一方面,处理(lǐ)大模型训练数据的底层技术所需的工具链也必须产品化和标准化。大模型在标准化技术服務(wù)的有(yǒu)力支撑下,可(kě)输出硬件适配、模型蒸馏和压缩、模型分(fēn)布式训练和加速、向量数据库、图数据库、模型互联互通等技术方案,提供自然语言处理(lǐ)、计算机视觉、跨模态、知识图谱等各类能(néng)力,让更多(duō)的企业、开发者可(kě)以低门槛地将大模型应用(yòng)于自身业務(wù)并构建行业垂直模型,从而促进人工智能(néng)在各领域广泛落地。

值得注意的是,大模型的开发和应用(yòng)虽然会对产业和经济发展带来巨大红利,但如果不加以合理(lǐ)管控,也会给國(guó)家和产业安全带来风险。一是数据泄露风险。大模型的训练、落地,都需要以海量的数据支撑,其中包含行业或个人敏感信息的数据。如果没有(yǒu)合理(lǐ)的数据脱敏和数据托管机制,则可(kě)能(néng)造成数据泄露,给行业和个人造成损失。二是模型安全风险。比如,插件可(kě)能(néng)被植入有(yǒu)害内容,成為(wèi)不法分(fēn)子欺诈和“投毒”的工具,危及社会和产业安全。

相关建议

以大模型训练数据為(wèi)抓手,标准制定和数据治理(lǐ)双管齐下。通过制定模型应用(yòng)规范,统一接口标准,促进行业规范化发展。可(kě)考虑对模型的合成数据进行托管,以加强监督,保障数据内容合规、权益清晰、流通顺畅。同时完善法律法规,优化政策制度,以多(duō)种途径与方式形成监管合力,严防恶意篡改模型和渗入有(yǒu)害数据等行為(wèi)。

构建大模型训练数据要素市场。厘清训练数据采集处理(lǐ)、合成数据服務(wù)、大小(xiǎo)模型互联互通、应用(yòng)API之间的产业链。加快数据要素市场建设,為(wèi)训练数据提供市场化定价,以利权益分(fēn)配与激励。

构建大小(xiǎo)模型共生发展、相互促进的良好生态。总體(tǐ)来看,目前國(guó)内外主流大模型在算法层面尚不存在代际差,但是在算力和数据方面存有(yǒu)差距。建议在通用(yòng)领域大力支持國(guó)内头部科(kē)技企业研发自主可(kě)控的國(guó)产大模型,同时鼓励各垂直领域在大模型基础上,利用(yòng)开源工具构建规范可(kě)控的自主工具链,既探索“大而强”的通用(yòng)模型,又(yòu)研发“小(xiǎo)而美”的垂直行业模型,从而构建基础大模型和专业小(xiǎo)模型交互共生、迭代进化的良好生态。

来源:中國(guó)金融杂志(zhì)

相关热词搜索:大模型,姚前